Künstliche Intelligenz

Interview: Mit Robotern sprechen

Künstliche Intelligenz steckt in Sprachassistenten wie Alexa oder Siri. Ein Interview mit der Sozialpsychologin Prof. Dr. Nicole C. Krämer von der Universität Duisburg-Essen über die Formen und Möglichkeiten der Mensch-Maschine-Kommunikation.

Von Hildegard Kriwet

Kann man im Verhältnis Mensch – Maschine von wirklicher Kommunikation sprechen?

Das ist ein besonderer Testfall menschlicher Kommunikation. Wie reagieren Menschen auf Roboter oder auf virtuelle Agenten, die sprechen? Verhalten sie sich ähnlich, wie wir es von der Mensch-Mensch-Kommunikation kennen? Unsere Studien zeigen, dass es auch bei der Mensch-Maschine-Kommunikation sehr starke soziale Reaktionen gibt. Die Menschen sagen zwar: "Ja, ich weiß, das ist eine Maschine und ich weiß, dass sie nicht wirklich sprechen kann." Aber es reichen schon ein paar kleine Interaktionen – zum Beispiel kurze Dialoge mit Siri oder Alexa, dass man so auf die Maschine reagiert wie sonst auch auf ein menschliches Gegenüber. Man hat vielleicht nicht das Gefühl, dass das ein Mensch ist, aber man reagiert so.

Das ist schon aus Studien aus den 1990er-Jahren in den USA bekannt. Damals gab es die ersten Programme, bei denen die Computer ganz einfache Textantworten geben konnten, manche auch schon mit Sprachausgabe. Seitdem wissen wir, dass ein großer sozialer Reiz entsteht, wenn man sich mit Sprache verständigen kann. Das waren damals ganz einfache Systeme, bei denen sich der Computer zum Beispiel nur bedankt hat, da konnte man noch keine großartige Konversation führen. Aber auch das hat als Anreiz gereicht, hat bei Menschen alle möglichen sozialen Reaktionen ausgelöst.

Wenn ein sprechender Computer zum Beispiel ein Gesicht auf dem Bildschirm hat, dann präsentieren sich die Leute auch sozial erwünschter. So wie im richtigen Leben, wo wir uns anderen gegenüber auch von der Schokoladenseite zeigen wollen. So verhält man sich auch Maschinen gegenüber. Es gibt auch Reaktionen auf nonverbale virtuelle Interaktion, aber Studien zeigen übereinstimmend, dass das Wichtigste die Stimme ist.

Roboter Nao wird von Menschen gesteuert

Wie verändert Künstliche Intelligenz die Kommunikation mit der Maschine?

Es gibt bisher nur ganz wenige Systeme, die schon eine sinnhafte Unterhaltung führen können. Alexa und Google können noch nicht so viel. Da hören Sie noch häufig die Antwort: "Ich habe Dich nicht verstanden." Viel ist auch heute noch vorprogrammiert und abhängig vom Programmierer, der sich auf vermutete Fragen witzige oder passende Antworten einfallen lässt. Um wirkliche autonome Kommunikation herzustellen, werden reale Nutzer*innenaussagen abgehört. Sagen die Leute vielleicht etwas, das Siri zum Beispiel noch nicht kennt oder versteht. Das ist das Material, mit dem die Sprachassistenten im großen Stil trainiert werden. Dieses "machine learning" – das maschinelle Lernen – funktioniert aber nur, wenn vorher Menschen das Abgehörte verstehen, einordnen und für den Sprachassistenten kodieren. Die Systeme werden also mit den Daten aus echten Gesprächen immer weiter gefüttert, und aus diesen Dialogen lernen die Sprachassistenten dann. Ein Beispiel: Wenn es um Fragen zu emotionaler Hilfeleistung geht, dann ist das vielleicht eine neue Kategorie, die immer weiter mit großen Datenmengen gefüttert wird. So verbessert die Maschine ihr Antwortpotential und lernt nach und nach immer passendere, von Programmierern vorformulierte, Antworten zu geben.

Vielen Nutzer*innen ist das nicht klar: Schon vor einigen Jahren wurde es ja als Skandal in den Medien verbreitet, dass da extern Menschen sitzen und sich anhören, was man zu Hause sagt. Ohne diesen Zwischenschritt können die Maschinen aber nicht besser werden: Die Menschen machen die Sprache zunächst für die Maschine semantisch handhabbar.

Aber das sind immer noch vorformulierte Antworten, die sich aus einer Menge von Anfragen ergeben – da gibt es keine wirkliche Interaktion mit einem individuellen Nutzer. Zumindest derzeit noch nicht.

Bereit zur Kommunikation: Der Sprachagent wartet auf menschliche Ansprache

Wie viel Feedback brauchen wir, um ein Gespräch nicht als künstlich zu empfinden?

Man darf nicht vergessen: Uns ist bewusst, dass wir mit einer Maschine sprechen – die Stimme hört sich auch künstlich an. Und es stört uns vielleicht auch nicht, dass die Maschine immer auf dieselbe Art antwortet. Wir haben ja eventuell auch Freunde, die zum Beispiel immer dieselbe Redewendung benutzen, das stört uns ja auch nicht. Hier spielt die Erwartung eine Rolle, wir wissen ja, dass die Antwort maschinenhaft ist.

Wir machen Studien, in denen wir den Teilnehmer*innen sagen: "Sie sprechen jetzt mit einem Menschen, der computervermittelt ist" - oder: "Sie sprechen jetzt mit einem Computer". Da finden wir dann relativ wenige Unterschiede.

Daraus schließen wir, dass Maschinen uns veranlassen, ähnlich zu reagieren wie auf normale Mitmenschen. Es ist zwiespältig – auf der einen Seite, auf der bewussten Ebene, wissen wir, dass es eine Maschine ist, und haben spezielle Erwartungen. Aber andererseits reagieren wir offensichtlich doch sehr stark auf soziale Reize der Maschine. Ein Beispiel: Wenn die Maschine ein Kompliment macht, dann können wir gar nicht anders, als uns gut zu fühlen. Es ist ein sehr starker sozialer Reiz, wenn uns jemand sagt: "Du hast ein tolles Kleid." Es würde sehr viel kognitive Kapazität erfordern, das nicht unmittelbar wirken zu lassen. Erst im zweiten Schritt würden wir das vielleicht hinterfragen.

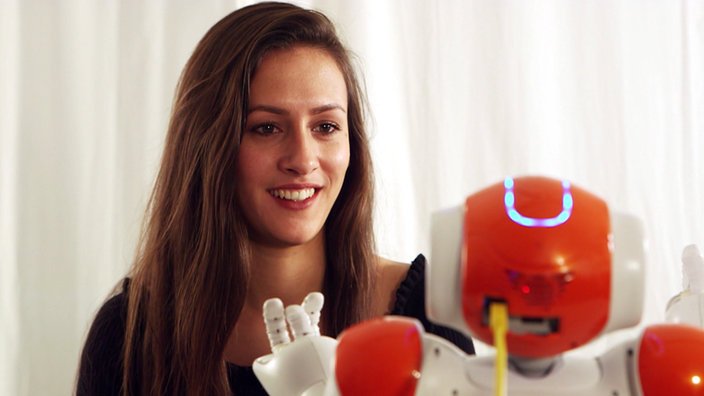

Studienteilnehmerin im Dialog mit dem Roboter Nao

Kann ein Sprachagent Gefühle beeinflussen?

Wir haben unterschiedliche Arten der emotionalen Beeinflussung gesehen. Man kann zum Teil auch Mitleid mit solchen Maschinen entwickeln. In einer Studie haben wir zum Beispiel einen kleinen grünen Roboter, einen Dinosaurier, gequält. Und da gab es eindeutige emotionale Reaktionen.

Wir haben jetzt in einer neueren Studie die Teilnehmer*innen darum gebeten, den Roboter nach einem Testvorgang schon mal auszuschalten. Bei der Hälfte der Personen hat dann der Roboter aber gesagt: "Bitte schalt mich nicht aus. Es wird immer so dunkel und ich bekomme Angst." Da hatten wirklich viele Leute Probleme, den Ausschaltvorgang auszuführen. Das sind Indikatoren, an denen wir sehen, dass Maschinen in der Kommunikation auch Emotionen auslösen. Das war der Roboter Nao, so ein kleiner, recht niedlich gestalteter Roboter. Da kann man nicht ausschließen, dass auch das kindchenhafte für die Reaktion eine Rolle gespielt hat. Meine Hypothese ist aber, dass, sobald eine Maschine spricht und ein Bewusstsein vorspiegelt, dies vorrangig ist und die Erscheinungsform egal. Wir haben also unterschiedliche Arten der emotionalen Beeinflussung.

Roboter Pepper wurde für Pflegeheime entwickelt

Wie kann man das nutzbar machen?

Im Bereich Pflegeroboter kann man diese Wirkung der Mensch-Maschine-Kommunikation im guten Sinne nutzbar machen. Der kleine Roboter Nao könnte in Altenheimen zum Beispiel leichte Fitnessübungen anleiten und zum Mitmachen auffordern. Oder er kann darauf programmiert werden, Funktionen zu übernehmen, die es Menschen erlauben, im Alter länger allein zu Haus zu wohnen. Stichwort: "ambient assisted living". Er könnte zum Beispiel dazu auffordern, regelmäßig Tabletten zu nehmen oder vorschlagen, soziale Kontakte aufrechtzuerhalten. An solchen Projekten haben wir auch mitgearbeitet, zum Beispiel an dem Projekt "KOMPASS" der Uni Bielefeld. Da wurde vor allem für ältere Menschen der virtuelle Tagesbegleiter "Billie" entwickelt, als Kommunikationsschnittstelle, der zum Beispiel an Termine erinnert hat, oder auch die Verbindung zu Bezugspersonen aufnehmen konnte.

Kann man Reaktionen manipulieren?

Wenn man über die sozialen Reize arbeitet, hat man viele Manipulationsmöglichkeiten in der Hand. Ähnlich wie bei menschlicher Überzeugungsarbeit. Solche sozialpsychologischen Erkenntnisse lassen sich auch in der Mensch-Maschine-Interaktion nutzen. Man kann soziale Reize so einsetzen, dass ein möglichst optimales Überzeugungsergebnis dabei herauskommt. Im Bereich online-Einkauf sind die Systeme von Amazon oder Google genau daraufhin entwickelt worden. In Zukunft kann man sich durchaus vorstellen, dass Alexa eingreift und stimmungsabhängig – nach Klang der gehörten Stimme – Vorschläge macht: "Du klingst traurig, also lass uns einen lustigen Film bei Amazon prime kaufen." Ist denkbar und wird sicher auch ohne ethische Gewissensbisse von Seiten der großen Unternehmen angeboten.

Diskutieren Sie ethische Fragen, wenn Sprachsteuerungen entwickelt werden?

Ja, in der Wissenschaft auf jedem Fall: Bei dem schon erwähnten "KOMPASS"-Projekt wurde sehr stark diskutiert, wie menschlich das Ganze sein darf, dass es nicht zu manipulativ werden darf. Wir wollten zum Beispiel nicht, dass beim Gegenüber der Eindruck entsteht, dass es keine Maschine ist. Da ist eine klare ethische Grenze. Auch was die Überzeugungsarbeit angeht, bei der man die beschriebenen sozialen Reize nutzt.

Ein Beispiel: Das Projekt "IMPACT" – die Erforschung des Umgangs mit künstlicher Intelligenz in ganz unterschiedlichen Altersgruppen vom Kind bis ins hohe Lebensalter. Da geht es zum Beispiel um die Frage der Transparenz: Wissen die Menschen, dass sie mit einer Maschine sprechen? Wie verändert sich die Kommunikation? Wie verändern sich die Beziehungen dadurch? In diesem Projekt arbeiten Psychologen, Ethiker, Rechtswissenschaftler und Informatiker zusammen.

In den Unternehmen kann das anders sein: Da geht es ja darum, möglichst überzeugend Dinge zu verkaufen.

Was die Rechtslage angeht: Der Rechtsstaat möchte ja immer, dass wir sehenden Auges Technologie nutzen und wissen, was damit verbunden ist. Beispielsweise ist die Frage wichtig, was entscheidend ist für die sogenannte ‚informierte Einwilligung‘ bei Entscheidungen. In Bezug auf KI-gestützte Systeme müssen wir klar überlegen: Wie muss man den Umgang gestalten, damit der Mensch auch weiß, dass er mit einer Maschine spricht und was mit den Daten passiert?

Quelle: SWR | Stand: 14.10.2020, 16:00 Uhr